Immer mehr Unternehmen setzen KI produktiv ein – etwa für Chatbots, Dokumentenverarbeitung, Prognosen oder Automatisierungen anderer Art. Wer dabei die Datenhoheit, die Kostenkontrolle und die technische Unabhängigkeit behalten möchte, kommt an einem GPU Server nicht vorbei.

Gerade beim Betrieb von unternehmenseigener KI zeigt sich: Die zugrunde liegende Infrastruktur entscheidet maßgeblich über Wirtschaftlichkeit, Performance und Compliance.

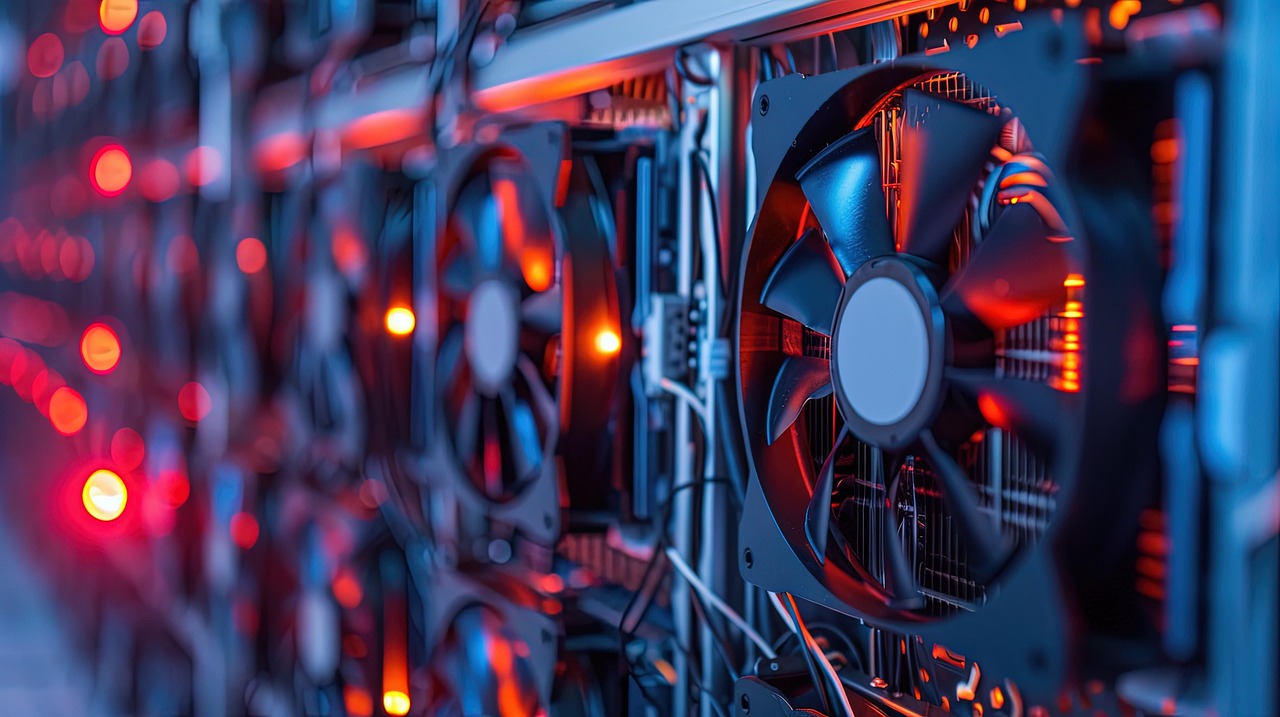

Ein GPU Server ist ein leistungsfähiger Server, der neben klassischen Prozessoren (CPUs) mit einer oder mehreren Grafikprozessoren (GPUs) ausgestattet ist. Diese GPUs sind speziell für sehr viele parallele Rechenoperationen optimiert – genau die Art von Berechnungen, die bei modernen KI-Modellen anfallen.

Im Gegensatz zu CPUs, die Aufgaben seriell und vielseitig abarbeiten, können GPUs tausende Rechenkerne gleichzeitig nutzen. Dadurch lassen sich KI-Modelle deutlich schneller trainieren und ausführen.

Informieren Sie sich zu unseren KI-Hosting-Angeboten – sichere, leistungsstarke KI-Infrastruktur für Unternehmen.

Moderne KI-Verfahren – insbesondere Machine Learning und Deep Learning – beruhen auf hochgradig rechenintensiven mathematischen Operationen. Diese Berechnungen müssen oft millionen- bis milliardenfach parallel ausgeführt werden, etwa beim Training neuronaler Netze mit großen Datenmengen. Klassische Server mit rein CPU-basierter Architektur sind dafür nur bedingt ausgelegt und stoßen schnell an Grenzen bei Performance, Energieeffizienz und Skalierbarkeit.

GPU-Server hingegen sind speziell für massiv parallele Rechenprozesse optimiert. Durch tausende Rechenkerne, hohe Speicherbandbreite und spezialisierte Beschleuniger eignen sie sich ideal für KI-Workloads wie Modelltraining, Inferenz und Big-Data-Analysen. Dadurch lassen sich Trainingszeiten drastisch verkürzen, Ressourcen effizienter nutzen und selbst komplexe KI-Modelle wirtschaftlich betreiben.

Für Unternehmen, die KI strategisch und datensouverän einsetzen möchten, ist die passende Infrastruktur entscheidend. Leistungsfähige GPU-Server schaffen die technische Grundlage, um moderne KI-Anwendungen kontrolliert, effizient und unabhängig zu betreiben.

Ein GPU-Server ermöglicht es Unternehmen, KI:

• selbst zu betreiben

• auf eigenen Daten zu trainieren

• dauerhaft produktiv einzusetzen

ohne dabei auf US-Clouds angewiesen zu sein.

Mit der passenden GPU-Infrastruktur eröffnen sich Unternehmen vielfältige Möglichkeiten, KI gezielt und praxisnah einzusetzen. Statt standardisierte Cloud-Dienste zu nutzen, lassen sich KI-Workloads individuell an eigene Prozesse, Daten und Anforderungen anpassen. GPU-Server bilden dabei die technologische Grundlage für leistungsfähige, skalierbare und datensouveräne KI-Anwendungen im Unternehmensumfeld.

GPU-Server werden heute typischerweise u.a. eingesetzt für:

• Interne KI-Assistenten und Chatbots (z. B. auf Basis eigener Dokumente)

• Eigene Sprachmodelle (LLMs) für Support, Vertrieb oder Wissensmanagement

• Dokumentenverarbeitung (Rechnungen, Verträge, Lieferscheine)

• Bilderkennung in Qualitätssicherung und Produktion

• Prognosen und Analysen (Absatz, Wartung, Nachfrage)

• Automatisierte Workflows mit KI-gestützter Entscheidungslogik

Gerade bei diesen Anwendungsfällen sollten sensible Unternehmensdaten die eigene Infrastruktur nicht verlassen. KI-Systeme verarbeiten häufig vertrauliche Informationen wie interne Dokumente, Kundendaten, Kommunikationsinhalte oder Produktionskennzahlen. Eine externe Verarbeitung birgt unnötige Risiken in Bezug auf Datenschutz, Kontrollverlust und Abhängigkeiten von Drittanbietern.

Der Betrieb auf eigener Infrastruktur stellt sicher, dass Datenhoheit, Sicherheitsanforderungen und Compliance-Vorgaben konsequent eingehalten werden können und unternehmenskritisches Wissen geschützt bleibt.

Beim Betrieb unternehmenseigener KI-Anwendungen lassen sich grundsätzlich zwei Phasen unterscheiden, die unterschiedliche technische und wirtschaftliche Anforderungen mit sich bringen: das KI-Training und die KI-Inferenz.

In der Trainingsphase wird ein KI-Modell neu aufgebaut oder auf unternehmenseigene Daten feinjustiert. Dabei verarbeitet das System große Mengen strukturierter und unstrukturierter Daten, passt Millionen bis Milliarden von Parametern an und durchläuft zahlreiche Iterationen. Dieser Prozess ist extrem rechenintensiv und zeitkritisch. GPUs sind hierfür prädestiniert, da sie komplexe mathematische Operationen parallel ausführen können und Trainingszeiten im Vergleich zu klassischen CPU-Systemen erheblich verkürzen. Gerade bei regelmäßigem Nachtraining oder der Anpassung von Modellen an neue Datenbestände sind GPU-Server ein entscheidender Produktivitätsfaktor.

In der Inferenzphase wird das trainierte Modell im operativen Tagesgeschäft eingesetzt. Typische Szenarien sind interne KI-Assistenten, Chatbots, automatische Dokumentenklassifizierung, Bilderkennung oder Prognosemodelle. Auch wenn die Rechenlast pro Anfrage geringer ist als beim Training, sind hier andere Faktoren entscheidend: geringe Latenzen, konstante Performance und hohe Verfügbarkeit. GPU-Server sorgen in diesem Umfeld für:

• schnelle und konsistente Antwortzeiten

• stabile Performance auch bei hoher Auslastung

• einen zuverlässigen Dauerbetrieb für produktive KI-Anwendungen

Für viele Unternehmen ist insbesondere die Inferenz auf eigenen GPU-Servern wirtschaftlich sinnvoll. Statt dauerhaft hohe nutzungsabhängige Kosten bei Cloud-Anbietern zu verursachen, lassen sich KI-Anwendungen planbar, kosteneffizient und datensouverän im eigenen Rechenzentrum oder bei einem vertrauenswürdigen Hosting-Partner betreiben.

Der Einsatz eines eigenen GPU-Servers bietet Unternehmen nicht nur technische Vorteile, sondern auch einen strategischen und wirtschaftlichen Mehrwert. Insbesondere beim produktiven Einsatz von KI-Anwendungen ergeben sich klare Argumente für eine eigene GPU-Infrastruktur.

Unternehmensdaten verbleiben im eigenen Rechenzentrum oder bei einem vertrauenswürdigen Hosting-Partner in Deutschland. Sensible Informationen wie Kundendaten, interne Dokumente, Kommunikationsinhalte oder Produktionsdaten werden nicht an unseriöse Cloud-Anbieter übertragen. Das erleichtert die Einhaltung der DSGVO, branchenspezifischer Compliance-Vorgaben sowie interner Sicherheitsrichtlinien erheblich und reduziert Risiken durch unklare Datenverarbeitung oder Zugriffe Dritter.

Im Gegensatz zu nutzungsabhängigen Cloud-Abrechnungsmodellen entstehen bei eigenen GPU-Servern klar kalkulierbare Infrastrukturkosten. Gerade bei dauerhaft laufenden KI-Anwendungen – etwa Chatbots, Analyse- oder Automatisierungssystemen – lassen sich Budgets besser planen und langfristig stabil halten. Unerwartete Kostensteigerungen durch steigende Nutzung oder Preisanpassungen von Cloud-Anbietern werden vermieden.

Unternehmen behalten die volle Kontrolle über Hardware, Software, Konfigurationen und Updates. GPU, Speicher, Laufzeitumgebungen und Sicherheitsmechanismen lassen sich gezielt an die eigenen Anforderungen anpassen. Gleichzeitig besteht die Freiheit, Modelle, Frameworks und Workflows unabhängig von Vorgaben oder Einschränkungen externer Plattformen zu betreiben und weiterzuentwickeln.

Ein GPU-Server für KI-Anwendungen zeichnet sich durch eine speziell auf parallele Rechenlasten ausgelegte Architektur aus. Zum Einsatz kommen dedizierte Rechen-GPUs, etwa aus den NVIDIA A-, H- oder RTX-Serien, die für Machine-Learning- und Deep-Learning-Workloads optimiert sind. Ein großer GPU-Arbeitsspeicher mit hoher Bandbreite ermöglicht es, auch umfangreiche Datenmengen und komplexe Modelle effizient zu verarbeiten, ohne ständig auf langsamere Speicherbereiche ausweichen zu müssen.

Ergänzt werden die GPUs durch leistungsstarke CPUs, die Aufgaben wie Orchestrierung, Datenvorverarbeitung, I/O-Management und die Steuerung von Trainings- und Inferenzprozessen übernehmen. Schnelle Storage-Systeme – etwa NVMe-basierte SSDs – sorgen dafür, dass Trainingsdaten, Modelle und Zwischenergebnisse mit minimalen Ladezeiten bereitstehen. Abgerundet wird das Gesamtsystem durch spezialisierte Software-Stacks wie CUDA, cuDNN sowie gängige KI-Frameworks, die den direkten Zugriff auf die GPU-Ressourcen ermöglichen und eine optimale Ausnutzung der Hardware sicherstellen.

Ein GPU-Server ist längst keine Nischenlösung mehr, sondern entwickelt sich zu einem zentralen Baustein moderner Unternehmens-IT. Immer mehr Geschäftsprozesse basieren auf datengetriebenen Auswertungen, Automatisierung und KI-gestützten Anwendungen, die dauerhaft, zuverlässig und performant betrieben werden müssen. Genau dafür liefern GPU-Server die notwendige Rechenleistung und Stabilität.

Unternehmen, die KI nicht nur experimentell, sondern produktiv in ihre Abläufe integrieren möchten, benötigen eine Infrastruktur, die technisch belastbar und wirtschaftlich sinnvoll ist. GPU-Server ermöglichen es, KI-Anwendungen auf eigenen Daten zu trainieren und im Tagesgeschäft effizient einzusetzen, ohne die Kontrolle über sensible Informationen zu verlieren. Wer KI langfristig, datensouverän und planbar betreiben möchte, schafft mit GPU-Servern die technische Grundlage für einen nachhaltigen und zukunftssicheren KI-Einsatz im Unternehmen.

Mit unserer KI Hosting-Lösung für Unternehmen nutzen Sie eigene KI-Modelle, bleiben unabhängig und schützen Ihre Daten – inklusive GPU-Leistung für optimale Performance.